Web Audio 是一个 HTML5 标准规范,它提供了在浏览器中进行音频处理的能力。使用 Web Audio 可以实现音频的播放、剪辑、合成、处理和分析等功能。本文将讲解如何在 Web Audio 中使用 getUserMedia 接口采集麦克风音频数据。

一文详解Web Audio浏览器采集麦克风音频数据

简介

Web Audio 是一个 HTML5 标准规范,它提供了在浏览器中进行音频处理的能力。使用 Web Audio 可以实现音频的播放、剪辑、合成、处理和分析等功能。本文将讲解如何在 Web Audio 中使用 getUserMedia 接口采集麦克风音频数据。

环境要求

在进行实验之前,确保你的浏览器支持 Web Audio 和 getUserMedia 接口。推荐使用 Chrome 浏览器,版本号应当大于 45。

步骤

步骤一:获取音频流

在 Web Audio 中使用 getUserMedia 接口获取音频流的方法如下:

navigator.getUserMedia = navigator.getUserMedia || navigator.webkitGetUserMedia || navigator.mozGetUserMedia;

navigator.getUserMedia({audio: true}, function(stream) {

// 在这里处理音频流

}, function(error) {

console.log('Error: ' + error);

});

getUserMedia 方法是一个异步方法,它接受三个参数:一个 options 对象,一个处理音频流的回调函数和一个错误回调函数。

options 对象中指定需要获取的音频数据类型,这里指定为 audio:true 表示需要获取麦克风音频数据。

处理音频流的回调函数中获得到音频流数据之后,可以在其上进行一系列操作,例如播放、剪辑、合成、处理和分析等。

错误回调函数中处理错误信息,例如无法获取音频流等。

步骤二:创建音频节点

获取到音频流之后,需要将其传递给 AudioContext 进行音频处理。AudioContext 是为Web Audio API提供的基础音频操作接口,它允许你创建音频处理图表和连接不同类型的音频节点。

接下来,我们使用 AudioContext 中的 createMediaStreamSource 方法创建一个 MediaStreamAudioSourceNode,将音频流数据传递给该节点:

var audioContext = new window.AudioContext();

var sourceNode = audioContext.createMediaStreamSource(stream);

步骤三:创建音频处理节点

对于我们采集到的音频数据,通常还需要进行一些处理。使用 Web Audio 我们可以非常方便地实现音频处理,例如音频放大、降噪、回声消除等。下面我们创建一个 JavaScriptNode,该节点创建时会调用指定的回调函数对音频数据进行加工处理:

var scriptNode = audioContext.createJavaScriptNode(4096, 1, 1);

scriptNode.onaudioprocess = function(audioProcessingEvent) {

// 在这里处理音频数据

}

在创建 JavaScriptNode 时指定了每次处理的音频缓冲区大小为 4096。关于缓冲区的大小,我们在回调函数中进行处理时尽量保持其小于 512。

步骤四:连接音频节点

接下来,我们需要将不同的音频节点进行连接。代码如下:

sourceNode.connect(scriptNode);

scriptNode.connect(audioContext.destination);

以上代码将音频流的终点进行连接,从而实现对音频流的处理或分析。

步骤五:采集音频数据

将音频节点连接好后,我们就可以读取音频数据并对其进行加工处理或分析了。代码如下:

scriptNode.onaudioprocess = function(audioProcessingEvent) {

var inputBuffer = audioProcessingEvent.inputBuffer;

var inputData = inputBuffer.getChannelData(0);

// 对 inputData 进行处理

}

通过 inputBuffer.getChannelData 方法,我们可以获取到音频数据,对其进行处理或分析。

示例

基于以上步骤,我们可以实现一个简单的麦克风音频数据采集应用。示例代码如下:

<!DOCTYPE html>

<html>

<head>

<meta charset="utf-8">

<title>Web Audio 浏览器采集麦克风音频数据示例</title>

</head>

<body>

<h1>Web Audio 浏览器采集麦克风音频数据示例</h1>

<p>麦克风音频数据:</p>

<pre id="audioData"></pre>

<script>

navigator.getUserMedia = navigator.getUserMedia || navigator.webkitGetUserMedia || navigator.mozGetUserMedia;

var audioContext = new window.AudioContext();

var sourceNode, scriptNode;

navigator.getUserMedia({audio: true}, function(stream) {

sourceNode = audioContext.createMediaStreamSource(stream);

scriptNode = audioContext.createJavaScriptNode(4096, 1, 1);

scriptNode.onaudioprocess = function(audioProcessingEvent) {

var inputBuffer = audioProcessingEvent.inputBuffer;

var inputData = inputBuffer.getChannelData(0);

document.querySelector('#audioData').textContent += inputData.toString() + '\n';

};

sourceNode.connect(scriptNode);

scriptNode.connect(audioContext.destination);

}, function(error) {

console.log('Error: ' + error);

});

</script>

</body>

</html>

总结

本文讲解了如何使用 Web Audio 浏览器采集麦克风音频数据。无论是制作音频录制应用程序、实现音频处理组件,还是分析音频流数据,Web Audio 都是一个优秀的解决方案。鼓励读者进一步探索和应用 Web Audio,发掘其更多的特性和应用场景。

本文标题为:一文详解Web Audio浏览器采集麦克风音频数据

基础教程推荐

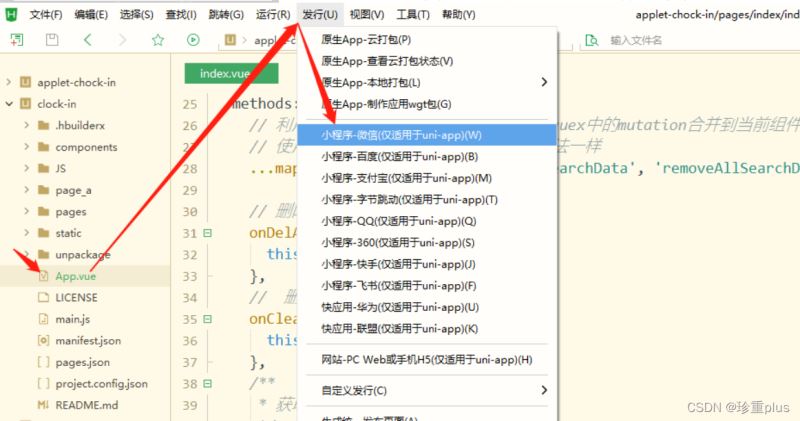

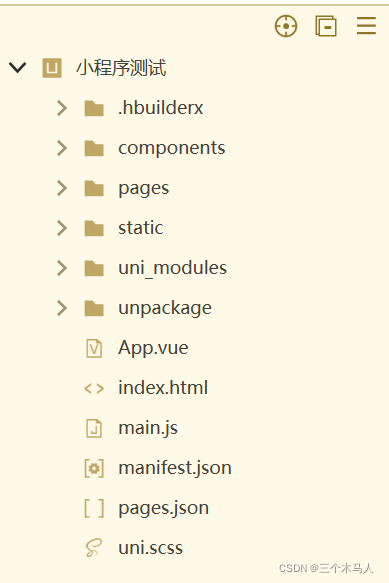

- vue离线环境如何安装脚手架vue-cli 2025-01-19

- 基于Vue制作组织架构树组件 2024-04-08

- 浅谈Vue2和Vue3的数据响应 2023-10-08

- js禁止页面刷新与后退的方法 2024-01-08

- this[] 指的是什么内容 讨论 2023-11-30

- Ajax实现动态加载数据 2023-02-01

- CSS3的几个标签速记(推荐) 2024-04-07

- 浅析canvas元素的html尺寸和css尺寸对元素视觉的影响 2024-04-26

- 关于文字内容过长,导致文本内容超出html 标签宽度的解决方法之自动换行 2023-10-28

- JS前端广告拦截实现原理解析 2024-04-22